Artificial Intelligence (AI) bzw. künstliche Intelligenz (KI) ist in aller Munde und löst hitzige Debatten aus.

- Die einen sehen in der Technologie den nächsten Produktivitätsschub, der uns Wohlstand und ein sorgenfreies Leben sichert.

- Andere sehen in der Technologie die Gefahr, dass Millionen von Arbeitsplätzen verloren gehen werden und damit Armut verstärkt und die Vermögensungleichverteilung noch beschleunigt wird.

- Und wieder andere sehen die Gefahr, dass diese Technologie das Ende der Menschheit in der heutigen Form bedeuten könnte.

Ich versuche mit diesem Artikel eine Einordnung diese Positionen in einer vereinfachten Form – und ich glaube, dass alle drei Positionen ihre Berechtigung haben – und nicht im ein Widerspruch zueinander stehen.

Vorab sollten wir uns die Frage stellen:

Warum ist AI so „besonders“?

Man kann die Sichtweise vertreten, dass in der Vergangenheit die Menschheit – ausgehend von bescheidenen Anfängen – durch Erfindungen und Technologie zuerst die Arme, die Beine, dann die Finger und jetzt halt die Gehirne automatisiert hat.

Für Spezialanwendungen ist AI auch schon lange im Einsatz und viel produktiver als menschliche Gehirne. Man denke nur an Gesichtserkennung, personalisierte Empfehlungen oder auch Diagnosesysteme zur Identifikation medizinischer Wirkstoffe. Mit der Veröffentlichung von ChatGPT und dem dahinter stehenden „Language Model“ ist eine neue Generation von Anwendungen verfügbar geworden, die das Potential viel deutlicher aufzeigt. Es ist eine Art „Alles-Könner-Technologie“ – oder zumindest gaukelt das Modell das vor.

In meiner Sichtweise zeigen diese Anwendungen aber alle erst ganz kleine Teile des Potentials auf, das in AI steckt. Wer glaubt, ChatGPT sei schon das, was man unter AI zu erwarten hat, der wird sich gewaltig täuschen. ChatGPT basiert auf Wahrscheinlichkeiten der Wortabfolge und ist keinesfalls intelligent im Sinne, dass das Modell etwas versteht. Was ChatGPT aber schon großflächig aufgezeigt hat ist, dass AI-Ergebnisse nicht vom Programmierer – sondern von den Daten abhängt, mit denen das Modell trainiert wurde.

Das ist die erste „Besonderheit“ von AI:

AI findet Lösungen, die nicht mehr vorprogrammiert sind, sondern die das Modell selber entwickelt

Diese „Besonderheit“ hat gewichtige Implikationen. Man hat es als „Erfinder“/“Programmierer“ nicht mehr in der Hand, was das Ergebnis sein wird. Man schafft sozusagen nur das „leere Gehirn“. Je nach Befüllung wird dieses Gehirn eigenständig Lösungen entwickeln und Entscheidungen fällen. Der Mensch, der das gestartet hat, kann aber gar nicht mehr nachvollziehen, auf welchem Weg das System eigentlich zu der Lösung gekommen ist.

Das ist so wie mit einem Baby. Auch dieses muss im Laufe seines Erwachsenwerdens mit Wissen und Erfahrung „gefüttert“ werden, um gute Entscheidungen fällen zu können. Bei spezifischen Anwendungen ist das keine Gefahr. Wenn ein AI-System Röntgen- oder MRT-Bilder auswertet und auf Krebsansätze untersucht, dann ist das je toll, wenn das System mit jeder richtigen und jeder falschen Entscheidung besser wird. Bei Systemen denen man einfach „das gesamte Internet“ als Datenquelle zur Verfügung stellt, sieht das schon anders aus. Das System lernt aus jedem Datenpunkt – sei er nun richtig oder falsch. Es ist kein Zufall, dass in der Vergangenheit AI-Modelle nach kurzer Zeit sexistische, homophobe oder rassendiskriminierende Ergebnisse gezeigt haben. Auch das hat das Modell im Internet „gelernt“.

Die zweite Besonderheit:

AI lernt simultan und aufbauend – ohne in jeder Generation wieder von vorne beginne zu müssen

Die menschliche Sprache und Schrift hat die Entwicklung des Menschen erst ermöglicht. Durch die Sprache war es möglich Erfahrungen von Mensch zu Mensch weiterzugeben. Es war nicht mehr notwendig, jeden Fehler selber machen. Man konnte von den Menschen um einen herum lernen.

Mit der Entwicklung der Schrift konnte man Erfahrungen und Erkenntnisse auch dokumentieren und damit breiter zugänglich machen. So konnten historische Genies wie Aristoteles oder Sokrates ihre Gedanken weitergeben, auch an Menschen, die diese Genies nie getroffen haben.

Mit der Entwicklung des Buchdrucks wurde Wissen plötzlich allgemein zugänglich. Und mit der Entwicklung des Internets haben wir heute diese Informationen alle nur ein paar Klicks entfernt.

Was aber als „Grundproblem“ geblieben ist: Jeder Mensch kommt ohne Erfahrungen und Wissen auf die Welt. Jeder Mensch muss alles von Grund auf selber und neu lernen. Auch wenn dies aufgrund der Rahmenbedingungen heute viel einfacher und produktiver geht als vor 500 oder 5.000 Jahren – jedes Kind beginnt bei Null und muss alles neu erlernen. Zwar können wir dabei das gesamte vorhandene Wissen nutzen, wir können aber leider nicht dort weitermachen, wo andere aufgehört haben. Manche von uns (vor allem als Wissenschaftler) leisten einen großartigen Beitrag dazu, dass das Wissen der Menschheit erweitert wird. Leider ist es aber so, dass dann, wenn solche speziell fähige Menschen – wie z.B. Einstein – sterben, es nicht hunderte Clone gibt, die dort weitermachen, wo er aufgehört hat. Die menschliche Evolution ist damit zwar grundsätzlich toll – aber halt auch langsam und eigentlich sehr unproduktiv.

Künstliche Intelligenz funktioniert da ganz anders. Wenn ein Mensch durch einen Fehler einen Unfall verursacht, dann hat dieser Mensch etwas für die Zukunft gelernt. Wenn ein AI-System einen Unfall verursacht, dann hat jedes Auto, das mit diesem System ausgestattet ist, etwas für die Zukunft gelernt.

Geoffrey Hinton – ein Pionier der Künstlichen Intelligenz – drückt das so aus: „Wir sind biologische Systeme und diese sind digitale Systeme. Der große Unterschied besteht darin, dass man bei digitalen Systemen viele Kopien desselben Gewichtungssatzes, desselben Modells der Welt hat.“ „Und all diese Kopien können getrennt voneinander lernen, aber ihr Wissen sofort weitergeben. Das ist so, als hätte man 10.000 Leute, und immer wenn eine Person etwas gelernt hat, wussten es automatisch alle.“

Diese Eigenschaft von KI – nicht wie beim Menschen nach einer Generation immer wieder auf Null zurückgesetzt zu werden – ist ein riesiger evolutionärer Vorteil. AI macht keinen Schritt mehr zurück, sondern lernt kontinuierlich dazu. Und selbst wenn es technisch so ist, dass ein neues System aufgesetzt wird – das neue System kann das Know-how des alten Systems in ganz kurzer Zeit übernehmen.

Die Entwicklung von AlphaGo durch die Google-Firma Deep-Mind ist dafür ein gutes Beispiel. AlphaGo wurde entwickelt um GO – ein Strategie-Brettspiel, das viel komplexer ist als Schach – zu spielen. Nach bescheidenen Anfängen gelang es im Jahr 2016 erstmals einen der Weltklassespieler (Lee Sedol) zu besiegen. Nur ein Jahr darauf im Mai 2017 gewann AlphaGO gegen den Weltranglistenersten Spieler (Ke Lie). Schon 6 Monate später publizierten die Entwickler die jüngsten Entwicklungsstufe von AlphaGo. Eine Version mit veränderter Software-Architektur und ohne Vorwissen über das Spiel, sondern ausschließlich mit den Spielregeln programmiert. Das war sozusagen wieder ein System in Analogie eines leeren Gehirns. Trotzdem – diese Version von AlphaGo war schon nach 3 Tagen (!) stärker als die AlphaGo-Version, die Lee Sedol besiegen konnte. Nur drei Monate später wurde AlphaZero vorgestellt. AlphaZero wurde auch nur durch das Einprogrammieren der Spielregeln vorkonfiguriert. Daraufhin trainierte AlphaZero gegen sich selbst. Innerhalb weniger Stunden (!) erlernte AlphaZero die Spiele Schach, Go und Shogi und war dann besser als jede Software, die bislang entwickelt wurde und damit weit übermenschlich. Was beeindruckend ist: Der KI werden bei diesem System keinerlei menschlichen Spielstrategien gezeigt. Die KI entwickelt alle Spielstrategien eigenständig. Und sie entwickelt dabei neue auch völlig unkonventionelle Spiel-Strategien.

Was bedeutet das? Was eine Maschine gelernt hat, das können dann potentiell alle. Man stelle sich vor, dass wir als Menschen jede Nacht im Schlaf alle Erfahrungen und das gebündelte Know-how aller Menschen dieser Welt „übermittelt“ bekommen würden! Wir wären jeden Morgen neu alle Einsteins, Aristoteles, Konfuzius, Da Vinci, Galileo, Hawkins, Elon Musk und Warren Buffett in einem.

Das führt zur dritten Besonderheit von AI:

AI lernt und entwickelt sich nicht linear, sondern exponentiell

Natürlich: der heutige Stand von AI ist meilenweit entfernt von der Intelligenz von z.B. Genies wie Einstein, Aristoteles oder Da Vinci. Heute ist AI (noch) viel weniger intelligent als man uns glauben machen will. Aber – und das ist der wichtige Aspekt – AI steht erst am Anfang – und die Fähigkeiten wachsen exponentiell.

Menschen tun sich grundsätzlich sehr schwer mit dem Verständnis exponentiellen Wachstums – menschliche Wahrnehmung ist linear. Das Beispiel vom chinesischen Bauern, der vom Kaiser einen Wunsch erfüllt bekommt, verdeutlicht das. Er wünschte sich ein Reiskorn auf das erste Schachbrett-Feld und dann von diesem eine Verdoppelung je Feld. In Summe wäre das eine Menge Reis, mit der alle heute lebenden Menschen für 400 Jahre täglich mit über einem Kilogramm Reis versorgt werden könnten!

Ray Kurzweil, der Chef-Visionär von Google, hat zum Thema des Tempos der technologischen Entwicklung schon 2001 in seinem Artikel “The Law of Accelerating Returns” die These formuliert, dass der technologische Fortschritt im gesamten 21.Jahrhundert äquivalent zum technologischen Fortschritt der vorangegangenen 20.000 Jahre sein wird. Und damals in der Altsteinzeit begannen die Menschen gerade erst systematisch Steinwerkzeuge herzustellen und als Jäger und Sammler unseren Planeten bevölkern. Nach dieser These wird das Äquivalent der Rechenleistung eines menschlichen Gehirns für Kosten von 1000 US$ in 2023 möglich. Durch die Weiterentwicklung der Technologie wird das Äquivalent der Rechenleistung eines menschlichen Gehirns schon im Jahr 2037 für 1 Cent (!) verfügbar sein. Das Äquivalent der gesamten biologischen Rechenleistung der Menschheit zusammen wird in 2049 für 1000 US$ verfügbar sein. Und das Äquivalent der gesamten biologischen Rechenleistung der Menschheit wird in 2059 schon für 1 Cent möglich sein.

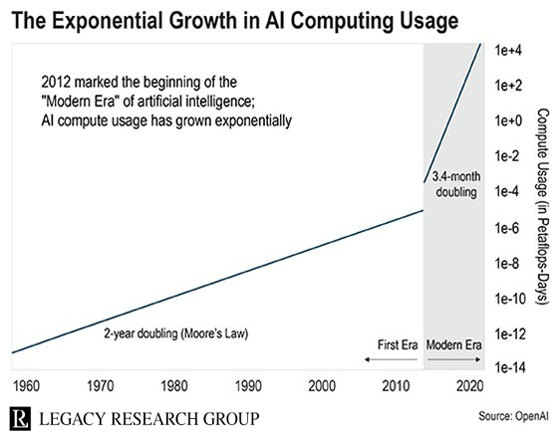

Können wir uns vorstellen, was das für die Entwicklung von AI bedeutet? Die Fähigkeiten von AI werden (neben Daten) maßgeblich durch die Rechenleistung bestimmt bzw. limitiert. AI (bzw. die dafür eingesetzte Rechenleistung) entwickelt sich noch viel schneller als die allgemeine technische Entwicklung, die Kurzweil beschrieben hat. Die Rechenleistung für AI hat sich nicht nur exponentiell, sondern sogar „stagged exponentiell“ vergrößert, wie die Darstellung unten zeigt. (Achtung: die Y-Achse auf dem Schaubild ist logarithmisch, d.h. die lineare Linie entspricht schon dem Reisfeldbeispiel mit der Verdoppelung alle zwei Jahre).

Was bedeutet das? Wenn wir die Tatsache akzeptieren,

- dass Künstliche Intelligenz über Zeit intelligenter wird und wir weiters akzeptieren,

- dass dieser Fortschritt exponentiell, analog der Rechenleistung von Computern wächst,

dann ist die Frage nicht, ob Maschinen irgendwann intelligenter sein werden als Menschen, sondern nur die Frage des „Wann„!

Und mit Intelligenz ist nicht die Fähigkeit gemeint, eine spezifische Aufgabe besser zu können, als wir Menschen (das kann AlphaZero auch), gemeint ist die allgemeine Fähigkeit kognitive Aufgaben besser lösen zu können, als wir Menschen. Allgemeine künstliche Intelligenz wäre in der Lage, jede menschliche Aufgabe zu übernehmen – inkl. der Erweiterung des menschlichen Wissens durch Forschung.

Um die Entwicklungslinie zu verdeutlichen, machen wir ein Gedankenexperiment: Nehmen wir an, dass wir heute eine künstliche Intelligenz haben, die z.B. nur 5% so gut ist, wie wir Menschen (immerhin sind Computer in vielen Bereichen Einzelbereichen ja schon besser als wir). Und nehmen wir weiter an, dass die Fähigkeiten der KI mit 50% pro Jahr wachsen (das entspricht der Wachstumsrate der Rechenleistung in den letzten Jahrzehnten).

- Wann wäre die Künstliche Intelligenz auf dem Niveau von uns Menschen?

- Und wann wären Maschinen unvorstellbare eine Mrd. mal so intelligent wie ein Mensch?

In dem Beispiel wäre schon im Jahr 2030 künstliche Intelligenz der menschlichen ebenbürtig, d.h. könnte alle Arten von kognitiven Problemen lösen, die wir Menschen auch lösen können. Und um das Jahr 2080 herum wären die Maschinen 1 Mrd. mal so intelligent wie wir Menschen! Mo Gadwad schätzt in seinem spannenden Buch „Scary Smart„, dass bereits im Jahr 2049 AI eine Mrd. mal intelligenter sein wird, als wir Menschen.

Es kommt hier gar nicht auf die Prognose des Zeitpunktes an – es geht darum, dass das Ergebnis unausweichlich ist. Eine künstliche Intelligenz, die eine Mrd. mal intelligenter wäre als ein Mensch, kann alles erfinden, sich selber weiterentwickeln und würde den Menschen mit seinem linearen Entwicklungspotential unbedeutend hinter sich lassen.

Man muss das schon in Perspektive sehen. Was macht uns Menschen zum „Herrscher bzw. zur Herrscherin über die Schöpfung„? Doch nur unsere Intelligenz! Wir sind nicht die schnellsten Lebewesen, wir sind nicht die Stärksten und auch nicht die Langlebigsten. Nur aufgrund unserer Intelligenz und der Fähigkeit Wissen zu vermehren und an nachfolgende Generationen weiterzugeben haben, wir uns vom Rest abgehoben. Das wäre dann ins Gegenteil verkehrt – eine künstliche Intelligenz wird unserer deutlich voraus sein. In welchem Verhältnis wird dann der Mensch zu AI stehen – oder umgekehrt in welchem Verhältnis AI dann zu uns Menschen stehen wird – das ist die große Frage. Dazu komme ich gleich noch.

Noch sind wir aber nicht so weit. Zuerst wollen wir uns im hier und heute die Frage stellen, welche Auswirkungen AI auf unser wirtschaftliches Leben hat – und damit auch welche Perspektive das auf uns als Anleger bietet.

AI in der Arbeitswelt

ChatGPT aufgezeigt, dass AI massiv Einfluss auf unseren Arbeitsalltag und auf unser wirtschaftliches Leben haben wird. So ziemlich jeder in der Technik ist sich einig, dass generative KI bzw. große Sprachmodelle wie ChatGPT einen Generationswechsel in Bezug auf das darstellen, was wir mit Software tun und was wir mit Software automatisieren können. AI wird nicht nur Serviceaufgaben übernehmen, AI wird schon bald auch ganze Filme generieren, Bücher schreiben, Häuser planen, LKWs auf der Autobahn fahren, komplexe medizinische Operationen durchführen und natürlich die Veranlagung von Vermögen übernehmen. All das ist die Übernahme von Tätigkeiten (oder zumindest große Teile davon), die bisher Menschen gemacht haben.

Das ist schlicht Automatisierung. Automatisierung ist aber kein neues Phänomen. Die Wirtschaft automatisiert seit 200 Jahren massiv. Und jedes Mal, wenn wir eine Welle der Automatisierung durchlaufen, verschwinden ganze Klassen von Arbeitsplätzen. Aber es entstehen auch neue Klassen von Arbeitsplätzen. Das geht nicht reibungslos, manchmal gehen die neuen Jobs an andere Leute mit anderen Qualifikationen und an verschiedenen Orten. Aber mit der Zeit nimmt die Gesamtzahl der Jobs nicht ab und wir sind alle wohlhabender geworden. Und das ist kein Zufall, sondern lässt sich wissenschaftlich belegen. (Benedict Evans erläutert das in seinem Artikel „AI and die Automatisation of Work“ sehr anschaulich).

Die Angst, dass durch neue Technologie Arbeitsplätze wegfallen – und es keine neuen geben wird – ist zwar verständlich. Sie beruht aber auf einem Irrtum – der „Lump of Labour Fallacy„. Das ist die falschen Annahme, dass es eine festgelegte Menge an Arbeit gibt, die erledigt werden muss. Folglich gäbe es weniger Arbeit für die Menschen, sobald eine Maschine etwas Arbeit übernimmt. Was dabei übersehen wird: Wenn es billiger wird, eine Maschine zu verwenden, um beispielsweise ein Paar Schuhe herzustellen, dann sind die Schuhe billiger, mehr Menschen können Schuhe kaufen. Und vor allem: Sie haben mehr Geld, das sie für andere Dinge ausgeben können. Wir entdecken neue Dinge, die wir brauchen oder wollen, und neue Jobs. Der Effizienzgewinn beschränkt sich nicht auf den Schuh: Im Allgemeinen wirkt er sich nach außen auf die Wirtschaft aus und schafft neuen Wohlstand und neue Arbeitsplätze.

Wir wissen also nicht, wie die neuen Arbeitsplätze aussehen werden, aber wir haben ein Modell, das nicht nur besagt, dass es immer neue Arbeitsplätze gegeben hat, sondern auch, warum das passieren wird.Es gibt noch einen zweiten wirtschaftswissenschaftlichen Ansatz, der die Auswirkungen deutlich machen kann – das Jevons-Paradoxon.

Im 19. Jahrhundert basierte die britische Marine auf Kohle. Großbritannien hatte viel Kohle, aber die Menschen machten sich Sorgen, was passieren würde, wenn die Kohle zur Neige ginge. Die Antwort der Ingenieure : Machen Sie sich keine Sorgen, denn Dampfmaschinen werden immer effizienter, sodass wir weniger Kohle verbrauchen. Jevons wies nach, dass das falsch ist. Er postulierte: „Wenn wir Dampfmaschinen effizienter machen, dann wird ihr Betrieb billiger, und wir werden mehr davon verwenden und sie für neue und andere Dinge nutzen, und deshalb werden wir mehr Kohle verbrauchen“ – und er hatte recht.

Man kann die Auswirkungen des Jevson-Paradoxons z.B. seit langem in unserem Bürobetrieb sehen. Büroarbeit begann ja damit, dass die Angestellten Dokumente einzeln von Hand abzuschreiben mussten. In den 1880er-Jahren produzierten Schreibmaschinen dann perfekt lesbaren Text mit der doppelten Wortzahl pro Minute, und mit Durchschlägen gab es ein halbes Dutzend Gratisexemplare. Mit Schreibmaschinen konnte ein Angestellter mehr als das Zehnfache produzieren. Einige Jahrzehnte später erledigten Addiermaschinen das Gleiche für die Buchhaltung und das Rechnungswesen: Anstatt Spalten mit einem Stift zu addieren, erledigt die Maschine dies für Sie, in 20 % der Zeit, ohne Fehler.

Wie wirkte sich das auf die Beschäftigung im Büro aus? Die Firmen stellten viel mehr Angestellte ein, weil sie produktiver einsetzbar waren und Dinge erledigen konnten, die man vorher gar nicht machen konnte. Automatisierung und das Jevons-Paradoxon bedeuteten mehr Arbeitsplätze im Büro. Wenn es billiger und effizienter wird etwas zu tun, dann nutzt man das um mehr zu machen – z.B. Analysen und Auswertungen, die das Unternehmen effizienter und besser machen.

Was bedeutet das in Summe? AI ist eine große Chance für weiteren Produktiviätsgewinn. Produktivitätszuwachs ist die Quelle, die das Wachsen unseres Wohlstands in den letzten Jahrhunderten ermöglicht hat. Dieser Produktivitätsgewinn ist auch der treibende Faktor für die überproportionalen Wertsteigerungen der Unternehmen in diesen Jahrhunderten – an der wir als Aktionäre teilhaben. AI und ihre Anwendungen sind deshalb eine gute Nachricht für die Menschen, für die Wirtschaft und für die Aktionäre. Natürlich wird es auch bei dieser Automatisierungswelle Friktionen geben. Diese können aber abgefedert werden, weil neues Potential entsteht.

Heißt das, dass alles gut und toll ist mit AI?

AI – eine Gefahr?

Was ist davon zu halten, wenn der „Vater“ der Technologie hinter Künstlicher Intelligenz Geoffrey Hinton seinen Job kündigt und die Entwicklung als „beängstigend“ einstuft. Was ist davon zu halten wenn 350 der führenden AI-Experten in einem offenen Brief vor den Gefahren warnen – konkret: „KI-Systeme mit menschlich-kompetitiver Intelligenz können gravierende Risiken für die Gesellschaft und die Menschheit darstellen“

Ich denke man muss das sehr ernst nehmen. Wir sollten bei den Gefahren vermutlich weniger die durch Science-Fiktion getriebene Vorstellung, dass wir von übermenschlichen Roboter-Maschinen ausgerottet werden, vor uns haben. Die Gefahr ist viel subtiler und heute schon real.

Ein Beispiel: Unsere gesamten Aktivitäten in Sozialen Medien ist schon AI-optimiert. Wir bekommen automatisiert und individuell Inhalte vorgeschlagen, die zu unseren Interessen passen. Und Inhalte, die unsere Überzeugungen formen und im Sinne des Confirmation-Bias verstärken. Das führt schon heute dazu, dass Menschen in ihrer Blase leben und täglich weiter davon überzeugt werden, dass alles richtig ist, was sie glauben – egal ob die Überzeugung jetzt objektiv richtig oder falsch ist. Dazu kommt, dass AI Dichtung und Wahrheit (zumindest derzeit) nicht auseinanderhalten kann. Und „falsche“ Beweise für falsche Behauptungen einfach generieren kann. Heute kann AI jedes Foto mit fiktivem Inhalt generieren, jeden Politiker eine Rede halten lassen, die nie stattgefunden hat oder fiktive Videos als Beweise vorlegen. Als Beispiel lohnt es sich das Kurz-Video anzusehen!

Schon heute ist die Emotionalisierung und Radikalisierung von Randgruppen viel stärker geworden. Auch heute schon gibt es Akteure, die bewusst Menschen gegeneinander aufzubringen versuchen, die Einfluss auf politische Kampagnen nehmen und die z.B. eine Destabilisierung unserer liberalen Demokratie zum Ziel haben. AI lernt daraus und kann das perfektionieren. Hohe Emotionalisierung und Betroffenheit generiert viel Traffic und ist damit positiv – wenn man diese Messlatte als Zielgröße hat.

Das heißt, alleine die Fähigkeit von AI – über das was wir täglich zu sehen und zu hören bekommen – unser Bewusstsein und unsere Überzeugungen zu lenken, ist schon extrem bedrohlich. AI kann vermutlich in 2035 ohne menschliche Hilfe noch keinen Nagel in eine Wand schlagen – aber AI wird es vermutlich schon in der Hand haben, Menschen gegeneinander aufzubringen, Bürgerkriege (oder auch Kriege) auszulösen und politische Interessen durchzusetzen. Und wenn die AI partout einen Nagel in der Wand haben will, dann wird sie einen Menschen finden, der den Nagel einschlägt.

Hier sind wir schon sehr nahe beim Bild, das wir Menschen über kurz oder lang „die neuen Affen“ sein könnten. Wie oben schon dargestellt – unsere dominante Stellung haben wir ja nur deshalb, weil wir noch die am höchsten entwickelte Intelligenz haben. Und diese dominante Stellung müssten wir (zu irgend einem Zeitpunkt in der Zukunft) abtreten an superintelligente Systeme künstlicher Intelligenz. Im Moment geht die Gefahr von AI sicher nicht von dieser selber aus – sondern von Menschen die dieses Werkzeug „böswillig“, „habgierig“ und vor allem „machthungrig“ einsetzen.

Langfristig wird die ganz kritische Frage aber sein – welches die (ethischen) Werte sind, die AI antreiben wird? Menschen haben ethische Werte, die deren Handlungen rationalisieren. AI bekommt heute genauso noch Rahmenbedingungen bzw. vorgegebene Werte mitgeliefert – analog den Spielregeln bei AlphaZero. Z.B. wird vorgegeben, dass Sprache nicht sexistisch sein soll, wie im Fall von Zielkonflikten entschieden werden soll und dass die Bauanleitung von Bomben nicht weitergegeben werden soll. Im bösartigen Fall wird aber eben auch mitgegeben, dass Emotionen geschürt und Menschen gegeneinander aufgebracht werden sollen.

Es ist damit keineswegs klar, welche Werte die „Richtigen“ sind und genauso wenig ist klar, wer diese Werte festlegt. Vielleich ist das auch gar nicht entscheidend, weil sich die Frage stellt, ob vom Menschen der AI vorgegebene ethische Werte grundsätzlich über Zeit haltbar sein werden? Auch das ist mit der Erziehung von Kindern vergleichbar – wenn wir versuchen diesen unsere Werte mitzugeben. Irgendwann in der Pubertät lehnen sie sich dagegen auf und rebellieren dagegen. Genau dasselbe könnte ja mit den Maschinen passieren, dass sie uns zum Beispiel sagen: „Es ist aber unethisch, dass du meine Handlungsmöglichkeiten eingrenzt, indem du mir fest eingebrannte Werte gibst. Das darfst du nicht. Ich bin ein autonomes System.„.

Man muss davon ausgehen, dass AI irgendwann eigene „ethische“ Werte entwickeln wird. Interessant wird es dann, wenn diese Systeme sich selbst verbessern, das heißt, wenn sie ihre Intelligenz auf sich selbst anwenden und sich selbst zu optimieren beginnen in hoher Geschwindigkeit. Wenn dann Menschen weiterhin versuchen, die Entwicklung zu lenken, dann bedeutet das, dass die künstlichen Intelligenzen durch das tendenziell irrationale, langsamere Handeln derer, die sie programmieren und kontrollieren, zurückgehalten werden. Sie werden in ihrem Potenzial, ihrer möglichen Funktionsfähigkeit begrenzt. Das ist – um nochmal im Bild von vorher zu bleiben – so, als ob Affen Menschen kontrollieren würden.

Die Gefahr des „ausser Kontrolle geraten“ sehe ich damit als absolut real an – und sie wird uns treffen, unabhängig davon, ob das in 10, in 30 oder erst in 50 Jahren der Fall sein wird. Aber was kann man tun, um die Gefahr einzugrenzen? Leider gibt es da gar nicht so viel. Alle Ideen künstliche Intelligenz sozusagen im „Käfig“ zu halten und nicht selbständig werden zu lassen, sind zum Scheitern verurteilt. Alle Ideen moralische Basiswerte fix vorzugeben, scheitern schon daran, dass wir uns nie einig würden, welches (global!) die richtigen und von allen akzeptierten Werte sind. Und dass sich mit der weiten Verbreitung der Technologie alle daran halten würden, ist auch illusorisch.

Ich glaube, dass die Zukunft des Zusammenlebens der Menschen mit AI wird sich daran entscheiden, welche Werte sich künstliche Intelligenz selber gibt. Und da kann man auch optimistische Erwartungen haben. Auch wenn AI im Moment durch die globalen Konflikte und menschlichen Verhaltensweisen eher Hass, Neid, Machtstreben und Verleumdung „lernt“ – es gibt Hoffnung. AI wird nicht emotional sein, sondern rational. AI wird auch philosophisch sein. Philosophen wie Platon, Aristoteles, Kant oder Nietzsche haben sich sehr intensiv mit Ethik befasst. Und deren Befund ist, dass Ethik die Unterscheidung zwischen richtig und falsch bzw. Trennung von dem, was moralisch gut ist, von dem, was moralisch schlecht ist. Ethische Verpflichtungen zielen insbesondere auf die Frage, wie wir miteinander umgehen, wie wir mit zukünftigen Generationen umgehen.

Wird AI ethische Grundwerte „lernen“ und ethische Verpflichtungen einhalten? Warum nicht! der große Philosoph Immanuel Kant hat postuliert, dass die normative Kraft ethischer Verpflichtungen von der Fähigkeit des Menschen zur Vernunft ausgeht. Wenn das stimmt, wenn ethische Verpflichtungen vernünftig und rational sind, dann müsste AI prädestiniert sein ethische Werte zu übernehmen. AI wäre ja der Inbegriff von Vernunft und Rationalität. Sicher können wir uns aber nicht sein. Die Philosophen Adam Smith oder David Hume würden zum Beispiel Kant widersprechen und sagen, dass das, was ethisch richtig oder falsch ist, auf der Grundlage grundlegender menschlicher Gefühle oder Gefühle festgelegt wird. Und AI geben wir diese Gefühle nur über unsere tatsächliche zwischenmenschliche Kommunikation als „Vorbild“ weiter.